数据投毒攻击详解:无人驾驶汽车与智能AI如何被黑客操控

tp官方网站下载 2025年3月8日 14:16:10 tp官方下载安卓最新版本2025 214

爬虫污染模型AI领域里,爬虫污染模型的问题很复杂。不仅有大量简单的爬虫,还有更复杂的爬虫加入。这些复杂的爬虫非常狡猾,简单的爬虫被模型识别并清除并不重要,但它们会利用简单爬虫作诱饵,导致模型被简单样本特征误导。这样,复杂的爬虫就能轻松达到目的。这就像一个巧妙的陷阱,无声无息地干扰着模型的运作。

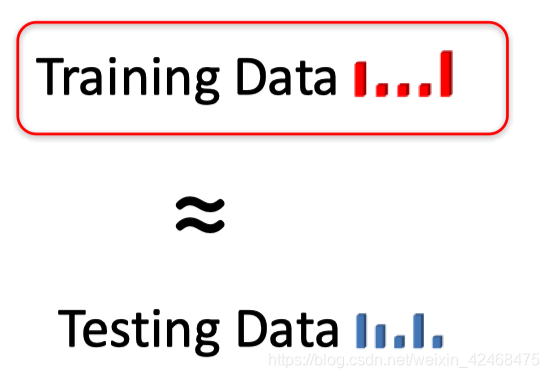

数据中毒原因数据中毒的问题值得我们深思。过去,机器学习方法未能充分认识到输入数据可能出错,有些人甚至故意破坏数据分布。我们常使用时间滑动窗口来建立模型,希望今天的数据分布与上周或每周一相似,但现实常常并非如此,攻击者便趁机发动攻击。

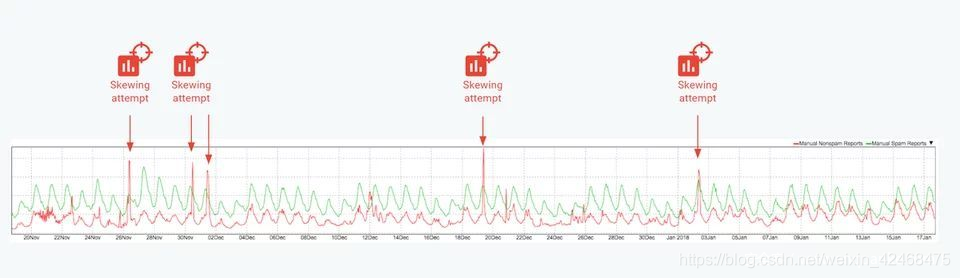

模型偏斜危害攻击者常用模型倾斜作为手段。他们篡改训练资料,导致模型在判断好坏输入时出现偏差,这影响了分类的精确度。比如,谷歌的垃圾邮件过滤器就遭遇过数据中毒的攻击。一些技术娴熟的垃圾邮件制造者故意将大量垃圾邮件伪装成正常邮件发送,结果分类器产生了偏差,我们的邮箱里就充斥了各种杂乱无章的邮件。

AI防御要点构建AI防护系统有几个要点要留意。例如,可以限制每个用户上传示例数据的数量,或者使用递减权重法。此外,只有模型在标准数据集上表现出色,才能被正式应用。这相当于为模型设置了多重关卡,旨在确保其安全稳定,减少被攻击的风险。

反馈武器化现象反馈系统变成了攻击的新方式。攻击者借助用户反馈机制来攻击合法用户和内容。以智能客服为例,若其评分功能无法有效抵御数据中毒,就可能受到干扰。所以,在实施惩罚模型前,必须验证反馈的真实性,并结合其他信息进行综合评估。

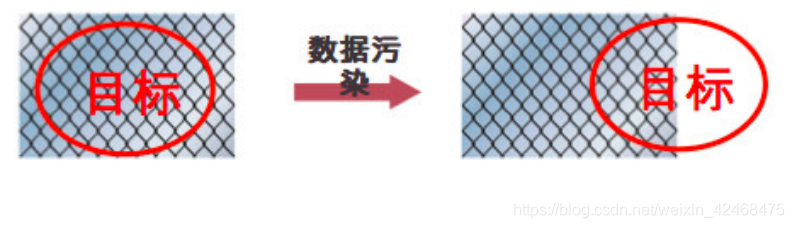

模型后门攻击模型后门是一种秘密的操作手段。它与直接发现错误的逃避攻击不同,只在输入特定样本时才会启动隐藏功能。有研究者在MNIST手写数据集上做了实验,通过添加后门数据集进行数据污染,攻击成功率高达99%以上,同时不会干扰模型正常的识别能力。黑客甚至将后门嵌入到网络结构里,对数据安全造成了潜在威胁。

关于AI未来发展过程中,我们应如何有效防止数据被污染,大家有什么看法?期待听到您的意见和交流。此外,请不要忘记为这篇文章点赞和分享!